Yahoo!ニュースのホームから、データ収集について検索し、検索結果の記事名とURLのデータ収集を自動化するプログラムをPythonを用いて作成しました。出力はCSVでもエクセルでも可能となっております。

このプログラムは過去にクラウドソーシングサイトである「ランサーズ」で受注を募集されていた案件内容を検索名だけ変えて作成したものです。

Yahoo!ニュースのシステムにより、ページのHTMLをすべて一括で取得するためには最下の記事が現れるまでスクロールすることと、「もっとみる」が消えるまでクリックし続けるようなプログラムを作る必要があるので、ただのスクレイピングとは異なり、Seleniumという自動でWebサイトを操作することが可能になるライブラリを使用しております。JavaScriptなどで作られたサイトである「動的なWebサイト」のデータ収集の自動化をすることに成功しています。

また、広告などの不必要なWebサイトは取り除いてデータ収集を可能にしていますので、ほしい記事のみ取得できます。

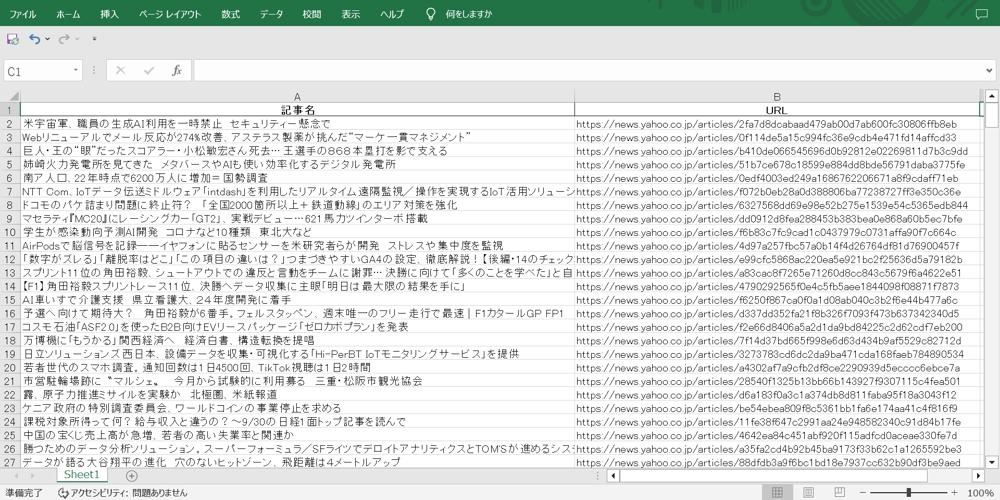

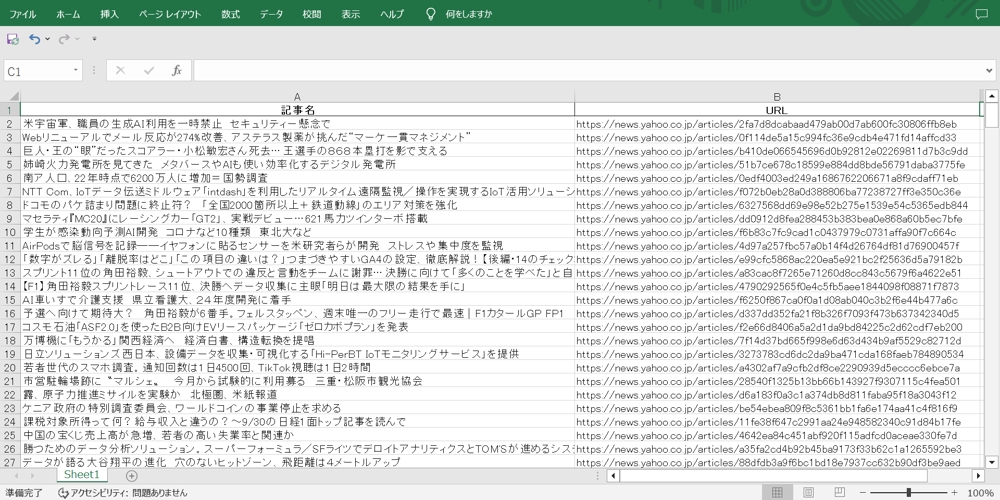

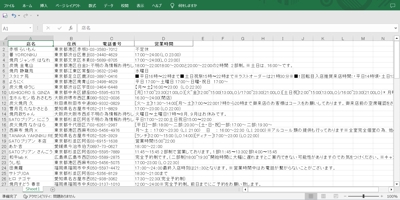

一枚目二枚目はエクセルに出力した際の出力結果です。一列目に記事名、二列目に記事のURLが掲示されています。ここからエクセルにより、さらに条件を絞って出力しなおすことも可能です。

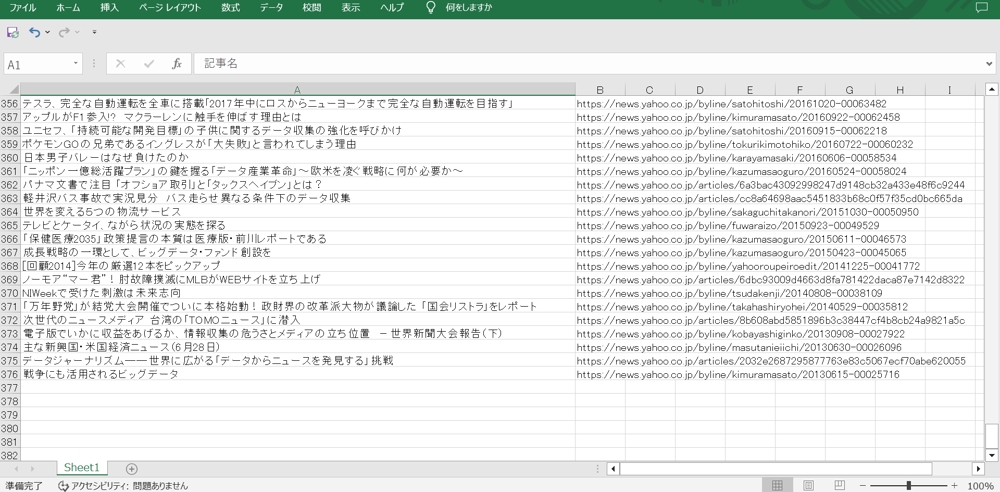

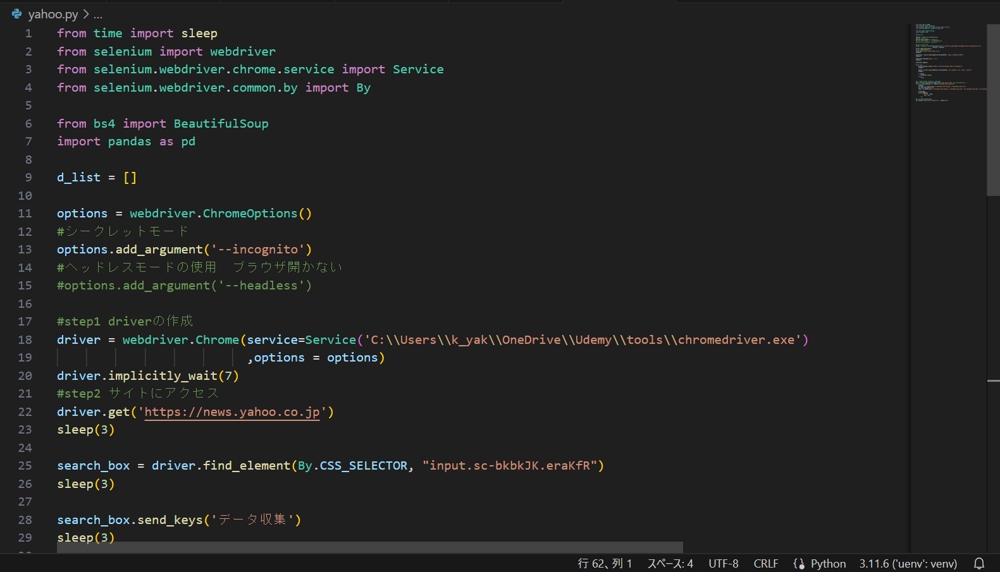

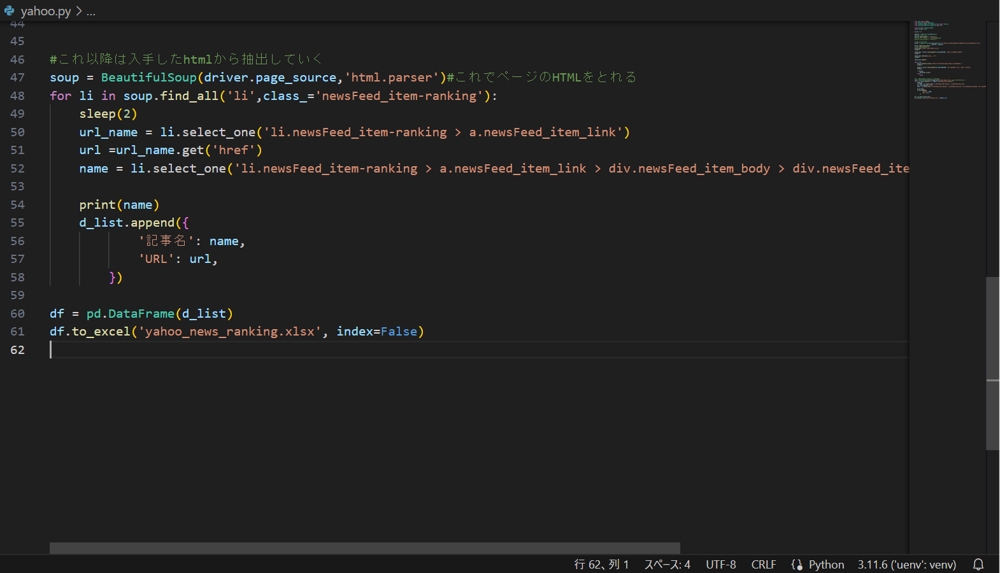

三枚目四枚目五枚目は実際のPythonのプログラムです。仮想環境が整えられていますので、ライブラリの更新があった際にも問題なく活用できます。

- カテゴリー

- データ収集・入力・リスト作成

- 業種

- IT・通信・インターネット

- 場所

- 愛知県

- 制作期間

-

1日

- 参考価格

-

5,000 円

- 最終更新日

-

2023年10月13日

制作者

最安値で取り組ませていただきます!!

-

3 件 満足0 残念

- 本人確認

- 個人

- 愛知県

プロフィールをご覧いただき、ありがとうございます。

現在、横浜国立大学在学の学生です。2年後に卒業を予定しております。

基本情報技術者の資格を所有しています。

Pythonを用いたwebスクレイピングによるデータ収集を得意としてます。その他、データ入力や未経験OKの案件を担当したいと考えておりますので、ご相談ください。

案件は最安値で取り組ませていただけるよう努力してまいります。また、納期を守ることはもちろん、丁寧なコミュニケーションを心がけております。学生という長所を活かして、どのような案件にも勤務時間を柔軟に対応することができます。ご連絡いただければ、すぐに対応できる態勢を整えております。どうぞよろしくお願いします。